常见SEO阿里云查看服务器内存服务器内存使用率优化有哪些最新的技术趋势?

阿里云服务器如何升级

服务器内存使用率优化正经历技术范式迁移,2025年呈现出CXL内存池化、持久内存、AI驱动内存管理、容器化优化、内存压缩等五大核心趋势,这些技术正在重塑数据中心架构。

一、CXL内存池化技术:突破"内存墙"瓶颈

CXL(Compute Express Link)已成为AI时代内存优化的关键技术标准。通过CXL协议,可以实现CPU、GPU、FPGA等异构计算单元之间的高效通信,支持缓存一致性和内存池化。

核心技术优势

内存池化机制:CXL通过集中式或分布式架构,将分散的内存资源整合为逻辑统一池,实现内存与计算的解耦。单系统最大可扩展到16TB内存资源池,相比传统服务器内存容量和带宽均扩大2倍。性能表现:在AI推理场景下,CXL方案使GPU显存占用降低82%(从36.6GB降至6.4GB),单token生成时间缩短至0.0698秒;在向量数据库场景中,应用吞吐量提升24%;内存数据库场景中,数据库吞吐量可提升92%。实际应用:阿里云已推出全球首款基于CXL 2.0 Switch技术的PolarDB数据库专用服务器,实现延迟低至百纳秒级,带宽吞吐达到数TB/s的远程内存访问。

二、持久内存(PMEM)技术:接近内存速度的持久化存储

Intel Optane DCPMM等持久内存技术提供接近内存速度的持久化存储,为高存储密集型服务器提供全新优化方案。

技术特点

性能优势:持久内存具有快速读写、低功耗和非易失性特点,访问延迟从毫秒级降至微秒级,特征检索速度提升8倍。应用场景:在MemKeyDB等内存数据库应用中,PMEM与DDR性能相当,达到DRAM的98%以上,但成本显著降低。在GNN训练场景中,PMEM方案较SSD方案训练效率提升4倍。配置建议:建议使用fsdax模式,结合NUMA感知技术,将进程绑定到正确的NUMA节点可显著提升性能。批量操作并在事务边界刷新,避免频繁调用force()带来的巨大开销。

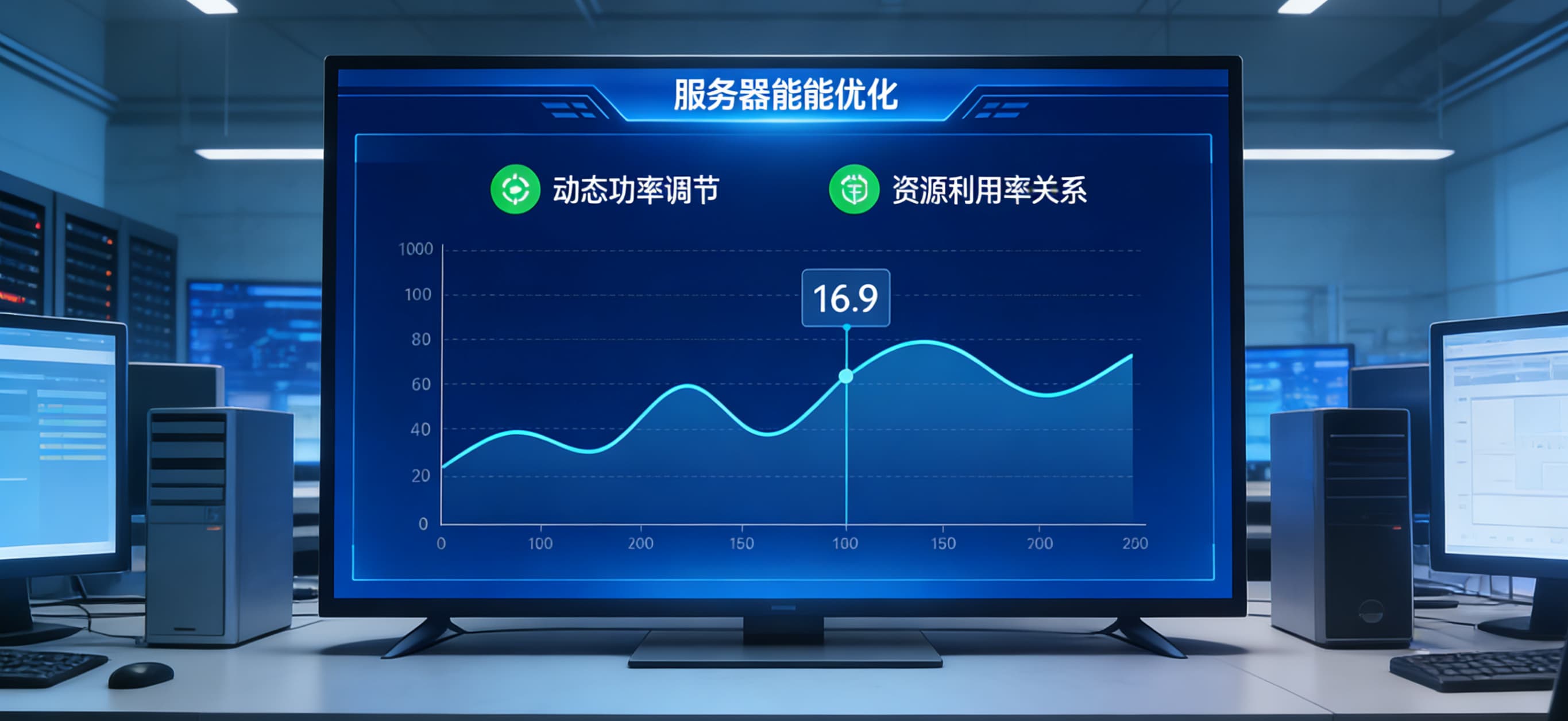

三、AI驱动的智能内存管理

AI算法正深度融入内存管理,通过机器学习预测内存使用趋势,实现自适应优化。

智能优化机制

阿里云服务器安全狗

动态预测:基于AI的智能预测模型可预测应用的内存使用趋势,提前进行优化。通过数据访问追踪、热度分层和迁移操作,将热数据存放在高速存储层,冷数据存放在大容量存储层。分层管理:智能分层引擎打通多层存储,在大语言模型场景中,对attention计算中的KVCache数据进行智能分层管理,大幅提升访问效率。实际效果:在MoE模型场景中,AI驱动的内存管理技术使GPU显存占用降低82%,单token生成时间缩短至0.0698秒,性能损失仅31%。

四、容器化环境内存优化

Docker容器的内存管理直接影响系统稳定性,生产环境必须显式设置内存限制。

核心优化策略

资源限制配置:使用mem_limit设置物理内存上限,mem_reservation设置软限制。典型配置中,高负载应用建议mem_reservation为mem_limit的70%,开发测试环境可适当调低以防止内存泄漏。监控与告警:通过docker stats实时监控容器内存使用,建议预留20%资源余量应对突发负载。设置OOM优先级(--oom-score-adj范围-1000到1000),确保关键服务不被终止。性能提升:通过优化基础镜像选择、多阶段构建、合理分配CPU与内存比例,容器内存占用可从85%降至45%,启动时间从45秒缩短至25秒。

五、内存压缩技术新突破

硬件加速的内存压缩技术正成为AI推理效率提升的关键。

技术革新

虚拟机连接云服务器

无损压缩算法:ZeroPoint等公司开发的专有"Cacheline算法"能以纳秒级延迟在64字节的超小颗粒度上实现1.5倍以上的无损压缩。在Llama 3.1 8B模型测试中,该技术使内存压缩接近1.5倍,在fp8格式上仍可提供1.33-1.43倍的无损压缩。KV缓存优化:针对LLM推理中的KV缓存,压缩技术可实现高达2.0倍的无损压缩,有效内存容量翻倍,极大缓解内存瓶颈。性能提升:硬件加速的压缩技术比现有软件压缩方法快1000倍,在超大规模数据中心可导致可寻址内存容量/带宽增加2-4倍,每瓦性能提高50%,总拥有成本大幅降低。

六、技术融合与未来展望

多技术协同:CXL与持久内存、AI驱动管理、容器化优化的融合,正在构建新一代内存管理架构。CXL 3.0及后续版本将支持多层级互连和动态资源分配,带宽翻倍至64 GT/s。标准化趋势:UALink等开放标准的出现,正在打破NVLink等专有方案的供应商锁定,推动AI生态向开放标准演进。未来方向:随着CXL与Chiplet、DDR5等技术的深度融合,AI模型将真正摆脱内存束缚,迈向"参数无界、算力无限"的新阶段。 这些技术趋势表明,服务器内存优化正从传统的静态配置向动态、智能、池化的方向发展,为AI时代的数据中心提供更高效、更灵活的内存管理解决方案。

阿里云服务器如何备份

推荐阅读

- 阿里云服务器集群方案美橙互联:云主机加速互联网创业实现0到1 2025-12-19 10:26:46

- 搭建云免流服务器视频跨境域名交易要注意什么? 2025-12-19 10:16:42

- 阿里云服务器怎样清空首批豆包手机使用者发声:微信能用但无法通过豆包调取,已有人7天无理由退货;官方:超16个软件登录异常,正积极沟通 2025-12-19 10:06:35

- 辽宁双线服务器云服务器淘宝卖虚拟商品,自动发货设置(详细教程) 2025-12-19 09:56:27

- 云服务器云管理融云韩迎出席AWS创业者之日:互联网通信云助力企业全球化征途 2025-12-19 09:46:24